汽车行业新闻

2023-09-20 10:20:46

以大脑为模型 研究人员开发出更强大的人工智能

盖世汽车讯 大多数人工智能系统都基于神经网络,其算法受到大脑中生物神经元的启发。然而,某些人类可以理解的视觉输入等信息,可能被人工神经网络(ANN)解释为完全不同的东西,比如图像分类系统将猫误认为是狗,甚至是无人驾驶汽车可能将停车信号误认为是优先通行标志。

(图片来源:东京大学)

由于不一定总是视觉性输入,看一眼就分析出系统出错的原因并不那么容易。攻击者可能利用这一点来破坏基于人工神经网络的系统,例如巧妙地改变预期输入模式,使其被误解。这样系统将出现错误行为,甚至可能出现问题。

研究人员针对此类攻击设计过一些防御技术,但存在一定的局限性。据外媒报道,东京大学医学系研究科(University of Tokyo Graduate School of Medicine)的应届毕业生Jumpei Ukita和Kenichi Ohki教授设计并测试了一种改善ANN防御机制的新方法。

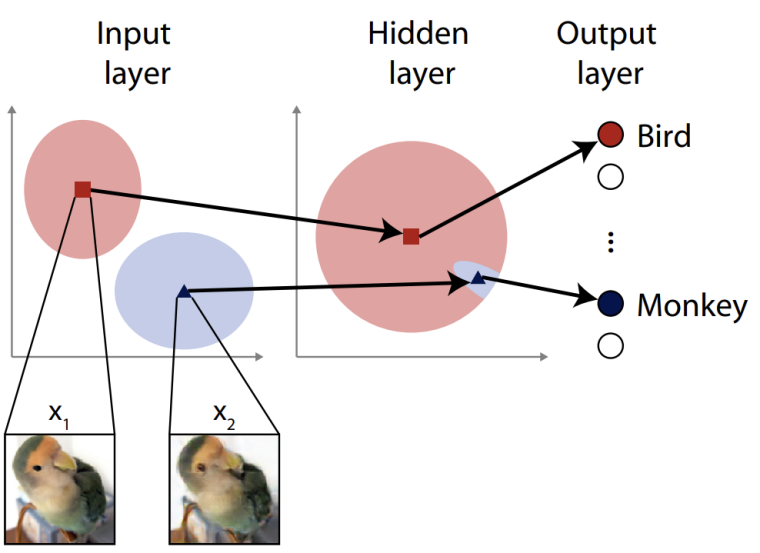

Ohki表示:“神经网络通常由虚拟神经元层组成。第一层通常负责通过识别与特定输入相对应的元素来分析输入信息。攻击者可能提供一些带有伪影(artifact)的图像,欺骗网络对其进行错误分类。针对这种攻击的常见防御措施,可能是故意在第一层中引入一些噪声,从而更好地适应视觉场景或其他输入集,但是这种方法并不总是有效。研究人员认为,可以通过超越输入层,深入到网络内部来改善这个问题。”

除了计算机,Ukita和Ohki还研究了人类的大脑,因此在人工神经网络中使用他们所知道的现象,不仅要在输入层中添加噪声,还要在更深的层中添加噪声。这种做法通常是避免采用的,因为在正常情况下可能影响网络的有效性。然而,结果正好相反,噪声提高了他们测试的人工神经网络的适应性,从而降低了其对模拟对抗性攻击的敏感性。

Ukita表示:“第一步是设计一种假设的攻击方法,使其攻击深度超过输入层。这种攻击需要承受输入层上具有标准噪声防御的网络的回弹(resilience)。这些被称为特征空间对抗示例。这些攻击的工作原理是,故意提供超出(而不是接近)ANN可以正确分类的输入。其诀窍是向更深层呈现微妙的误导性伪影。一旦这样的攻击表现出危险性,研究人员就会将随机噪声注入网络中更深的隐藏层,以提高它们的适应性,从而提高防御能力。结果证明这是有效的。”

该团队希望进一步开发这项技术,使其能够更有效地抵御预期攻击,以及尚未测试过的其他攻击类型。目前的防御仅针对特定类型攻击。Ukita表示:“未来的攻击者可能会考虑避开这项研究中提到的特征空间噪声。事实上,进攻和防御是同一枚硬币的两面,是一场双方都不会退缩的竞赛。因此,研究人员需要不断迭代、改进和推出创新想法,以保护大家日常都在使用的系统。”

【来源:盖世汽车】

【作者:Elisha】

0条评论